W maju opublikowano w serwisie NBER badanie potwierdzające to o czym się od przynajmniej kilku lat mówiło w sektorze inwestycyjnym: większość z odkrytych w badaniach empirycznych anomalii rynkowych jest wynikiem znęcania się nad danymi i nie ma praktycznej wartości dla inwestorów.

Problem p-hackingu w badaniu anomalii rynkowych znany jest od wielu lat. Badacze w taki sposób pracują z danymi, technikami badawczymi i hipotezami by uzyskać wynik istotnie statystycznie. Taka postawa wynika ze skrzywienia w publikacjach: publikowane są niemal wyłącznie pozytywne wyniki (bardzo trudno jest opublikować artykuł z testem jakiejś hipotetycznej anomalii, który jej nie potwierdził) i nie publikowane są prace replikujące poprzednie badania. W ogóle replikowanie uchodzi za coś bardzo mało kreatywnego, rozwojowego.

To skrzywienie w publikacjach jest zapewne w dużym stopniu generowane przez postawę redaktorów periodyków akademickich, którym zależy na publikowaniu przyciągających uwagę i generujących cytowania artykułów. Rozwój sektora inwestycyjnego i możliwość przeniesienia kariery z uniwersytetu do firmy inwestycyjnej/funduszu hedge, wraz ze stosownym wzrostem dochodów, tworzy dodatkową presję na znajdowanie istotnych statystycznie anomalii rynkowych. Warto przy tym pamiętać, że podobne skrzywienie publikacji pozytywnych wyników, z jego konsekwencjami, występuje także przy mniej rygorystycznych testach publikowanych w prasie biznesowej i blogach.

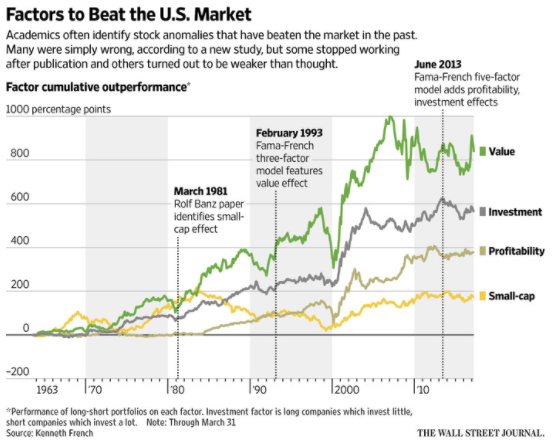

Kewei Hou, Chen Xue, Lu Zhang ponownie zbadali 447 wcześniej odkrytych anomalii rynkowych i wykazali, że większość z nich nie przeszła ponownego testu. W zależności od przyjętych kryteriów Hue, Xue i Zhang wyeliminowali od 64% do 85% anomalii. Uniwersum ponownie badanych anomalii obejmowało popularne podgrupy takie jak wartość, momentum, poziom inwestycji, zyskowność, jakość wyników finansowych i płynność. Najsłabiej wypadła ta ostatnia podgrupa, w której ponowne badania wyeliminowały 93% anomalii.

Nie dziwi więc, że wynikom badania Hue, Xue i Zhanga poświęcono sporo uwagi w mediach biznesowych. O pracy Replikowanie Anomalii pisał między innymi Bloomberg i Wall Street Journal. W obydwu tekstach zwrócono uwagę na najważniejszą przyczynę wyeliminowania tak dużego odsetku anomalii w testach Hue, Xue i Zhanga. Niestety informacja o tym pojawia się dopiero po kilku akapitach co stawia w niekorzystnej sytuacji czytelników mediów elektronicznych zadawalających się tytułem i kilkoma zdaniami wstępu. To samo dotyczy także innej kluczowej informacji: ponowne testy przetrwały, choć ze słabszymi wynikami, konwencjonalne definiowana wartość i momentum – a więc anomalie kluczowe dla segmentu inwestycyjnego znanego jako smart beta.

Wróćmy do powodów wyeliminowania tak dużego odsetka anomalii. Co było tego główną przyczyną? Sami autorzy nie mają w tej kwestii wątpliwości. Podkreślają, że tym czym ich replikacja różni się od oryginalnych badań jest podejście do mikro-spółek. Ten segment stanowi 3% kapitalizacji całego amerykańskiego rynku ale obejmuje aż 60% wszystkich notowanych spółek. Typowy test anomalii obejmuje sklasyfikowanie wszystkich spółek na podstawie jakiegoś kryterium, na przykład wskaźnika cena/zysk, i zajęcie długiej pozycji na 10% spółek z najlepszych wskaźnikiem (decylu „najtańszych” spółek) i krótkiej pozycji na 10% spółek z najgorszym wskaźnikiem (decylu „najdroższych” spółek). Mikro-spółki przez swoją charakterystykę częściej pojawiały się w testowanych portfelach niż wynikałoby to z ich liczebności. Co więcej wielu badaczy tworzyło portfele z równym udziałem spółek a nie udziałem ważonym kapitalizacją.

Efekt opisanych wyżej czynników był taki, że wyniki wielu badań anomalii rynkowych generowane były przez mikro-spółki stanowiące niewielką część ważonego kapitalizacją uniwersum inwestycyjnego. Mało tego, ze względu na małą płynność i wysokie koszty transakcyjne wiele mikro-spółek nie jest dostępnych dla inwestorów, zwłaszcza dla dużych inwestorów instytucjonalnych*. Hue, Xue i Zhang w swoich testach drastycznie obniżyli znaczenie mikro-spółek (między innymi przez ważenie kapitalizacją rynkową) bo uznali, że nie ma technicznych możliwości eksploatowania anomalii na tych spółkach

Moim zdaniem badania Hue, Xue i Zhanga stanowi cenną lekcję dla wszystkich indywidualnych inwestorów próbujących swoich sił w testowaniu hipotez inwestycyjnych na danych historycznych. Przypomina, że kryteria takich testów muszą mieć solidne oparcie w rynkowej rzeczywistości. W innym przypadku uzyskane w testach wyniki nie będą mieć żadnego przełożenia na wyniki opartej na nich strategii. Hue, Xue i Zhang skupili się na problemie dostępności inwestycyjnej mikro-spółek i wysokich kosztów transakcyjnych w tym segmencie. Przy obecnym poziomie płynności na warszawskiej giełdzie, zwłaszcza poza segmentem blue chipów, jest to problem, który koniecznie należy wziąć pod uwagę.

Weźmy pod uwagę dzisiejsze notowania: około połowa spółek z notowań ciągłych zanotowała obrót poniżej 13 000 złotych. Na 1/10 spółek w ogóle nie handlowano. Nawet dla niezbyt dużego inwestora indywidualnego, zwłaszcza stosującego strategie zakładającą transakcje na otwarcie lub zamknięcie sesji, skrajnie niska płynność na połowie notowanych spółek albo uniemożliwi stosowanie strategii albo obniży jej wyniki (bo zlecenie kupna spowoduje wzrost ceny).

Problem niskiej płynności i mikro-spółek to tylko jedno z zagadnień związanych z używaniem rozsądnych kryteriów testów danych historycznych. Z rozmów z inwestorami przekonałem się na przykład, że wielu testuje strategie przy założeniu zawierania transakcji na zamknięcie sesji (lub świeczki), na której wystąpił sygnał (a nie na otwarciu kolejnej).

Innym problemem mogą być splity, resplity, odcięcia praw poboru (albo gigantyczne wezwania na akcje własne jak w przypadku iAlbatrosa ostatnio) pozostawiające ślady w danych historycznych i w przypadku części testów mogące zaburzyć ich wyniki. Być może najlepiej znanym problem dostosowania badań historycznych do rzeczywistych warunków rynkowych jest konieczność uwzględnienia wycofanych z obrotu spółek, czyli neutralizowania survivorship bias.

Inwestorzy próbujący swoich sił w testach historycznych hipotez inwestycyjnych powinni więc pamiętać o dwóch ważnych kwestiach. Po pierwsze, muszą sprawdzić czy uzyskiwane wyniki nie są generowane przez wąską grupę specyficznych spółek lub nieprawidłowości w samej bazie danych. Po drugie, muszą się upewnić, że przyjęte kryteria pozwolą im stosować strategię w czasie rzeczywistym przy założonych w strategii kosztach transakcyjnych.

* Mikro-spółki nie są inwestowalne by użyć kalki z angielskiego

Niezależnie, DM BOŚ S.A. zwraca uwagę, że inwestowanie w instrumenty finansowe wiąże się z ryzykiem utraty części lub całości zainwestowanych środków. Podjęcie decyzji inwestycyjnej powinno nastąpić po pełnym zrozumieniu potencjalnych ryzyk i korzyści związanych z danym instrumentem finansowym oraz rodzajem transakcji. Indywidualna stopa zwrotu klienta nie jest tożsama z wynikiem inwestycyjnym danego instrumentu finansowego i jest uzależniona od dnia nabycia i sprzedaży konkretnego instrumentu finansowego oraz od poziomu pobranych opłat i poniesionych kosztów. Opodatkowanie dochodów z inwestycji zależy od indywidualnej sytuacji każdego klienta i może ulec zmianie w przyszłości. W przypadku gdy materiał zawiera wyniki osiągnięte w przeszłości, to nie należy ich traktować jako pewnego wskaźnika na przyszłość. W przypadku gdy materiał zawiera wzmiankę lub odniesienie do symulacji wyników osiągniętych w przeszłości, to nie należy ich traktować jako pewnego wskaźnika przyszłych wyników. Więcej informacji o instrumentach finansowych i ryzyku z nimi związanym znajduje się w serwisie bossa.pl w części MIFID: Materiały informacyjne MiFID -> Ogólny opis istoty instrumentów finansowych oraz ryzyka związanego z inwestowaniem w instrumenty finansowe.